[Strategiebasierte Evaluation einer formativen Simulationsprüfung berufsrelevanter Kompetenzen für Medizinstudierende]

Sarah Prediger 1Julia Gärtner 1

Lea Jebram 1

Sigrid Harendza 1

1 Universitätsklinikum Hamburg-Eppendorf, III. Medizinische Klinik, Hamburg, Deutschland

Zusammenfassung

Zielsetzung: Eine strategiebasierte Evaluation von neuen Lehr- oder Prüfungsformaten empfiehlt sich, um deren Eignung vor einer möglichen Integration in ein medizinisches Curriculum zu überprüfen. Das Ziel des Projektes war es, ein etabliertes formatives kompetenz- und simulationsbasiertes Prüfungsformat für Medizinstudierende standardisiert zu evaluieren.

Projektbeschreibung: Medizinstudierenden wurde zum Ende ihres Studiums in einer realitätsnahen Simulation eines ersten Arbeitstags im Krankenhaus die Gelegenheit gegeben, ihre ärztlichen Kompetenzen zu überprüfen und auf der Basis von Selbsteinschätzung und Feedback weiterzuentwickeln. In den Jahren 2020 bis 2023 nahmen insgesamt 879 Studierende teil. Darunter waren 707 Studierende im Praktischen Jahr (PJ) und 172 Studierende vor dem PJ. Das Simulationsformat wurde auf Basis der Stanford-Kriterien zur Evaluation von klinischer Lehre standardisiert ausgewertet. Die Freitextkommentare wurden inhaltsanalytisch mit MAXQDA ausgewertet.

Ergebnisse: Die Qualität des Trainings, die praktischen Lerninhalte und Aspekte der einzelnen Trainingsphasen sind die wichtigsten Themenbereiche der Studierenden-Bewertung. Das Lernklima, die Leitung sowie die erhaltenen Bewertungen und das Feedback werden positiv beschrieben. Es zeigen sich außerdem deutliche Hinweise, dass das Simulationsformat das Verstehen und Behalten fördert und selbstgesteuertes Lernen gut unterstützt. Insgesamt bewerten die Teilnehmenden das Lehrformat im Mittel mit der Schulnote 1,26±,45. Einige Evaluationsergebnisse wurden bereits in der Anpassung der Simulation umgesetzt.

Schlussfolgerung: Die Integration des Simulationsformates in medizinische Curricula kann auf Basis dieser Evaluation empfohlen werden. Eine Weiterentwicklung des Formates ist ebenfalls möglich.

Schlüsselwörter

Evaluation, Feedback, formative Prüfung, Kommunikation, Kompetenzen, Simulation

1. Einleitung

Verantwortliches ärztliches Arbeiten und Handeln wird mit der Approbation bzw. ab dem ersten Tag der ärztlichen Weiterbildung von Absolvent*innen des Humanmedizinstudiums erwartet. Hierfür ist das Erwerben von Kompetenzen erforderlich, die im Nationalen Kompetenzbasierten Lernzielkatalog Medizin (NKLM) abgebildet sind [https://nklm.de/zend/menu] und im sechsjährigen Studium erworben werden sollten. Da Kompetenz die Fähigkeit ist, in einem vorgegebenen Kontext in verantwortlicher und adäquater Weise unter Einbindung von komplexem Wissen, Fertigkeiten und Haltungen zu agieren [1], [2], bieten sich Simulationsformate zum Lernen und Prüfen von Kompetenzen an, um verantwortliches und kompetentes ärztliches Handeln abzubilden. Bevor neue Lehr- oder Prüfungsformate in ein Curriculum integriert werden, empfiehlt es sich, diese zunächst als freiwillige Angebote zu etablieren und auf ihre Eignung zu evaluieren.

Mit dem Referentenentwurf des Bundesministeriums für Gesundheit, der auch „die Umgestaltung der Prüfungen und die Einführung neuer, moderner Prüfungsformate“ ([3], S.1) vorsieht, sollen unter anderem die Kommunikation mit Patient*innen in Anamnesegesprächen und das medizinische Management von Patient*innen stärker abgebildet werden ([3], S.14). Für das Praktische Jahr (PJ) ist außerdem vorgesehen, eine Mindestzahl an strukturierten Vorstellungen von Patient*innen zu absolvieren ([3], S.35f.). Weiterhin sollen die Universitäten dazu verpflichtet werden, Lehrveranstaltungen anzubieten, die auf den dritten Abschnitt der Ärztlichen Prüfung vorbereiten sollen [3].

Das übergeordnete Ziel des Projektes war es daher, ein etabliertes Format [4] auf seine Eignung zur Integration in das Curriculum zu evaluieren, das Medizinstudierende Feedback-basiert beim Erwerb und bei der Selbstreflexion ärztlicher Kompetenzen unterstützt. Dafür wurde Studierenden in einer realitätsnahen Simulation eines ersten Arbeitstags im Krankenhaus [4] die Gelegenheit gegeben, ihre ärztlichen Kompetenzen zu überprüfen und auf der Basis von Selbsteinschätzung und Feedback weiterzuentwickeln. Die Evaluation dient der Verbesserung der Lehre und ist somit deren inhärenter Teil [5], wobei die Lehrqualität ein mehrdimensionales Konstrukt ist. Die Strategie der Evaluation folgte methodisch und praktisch im Wesentlichen den im Positionspapier des GMA-Ausschusses „Lehrevaluation“ dargestellten Empfehlungen [6].

2. Projektbeschreibung

Im vorliegenden Projekt wurde eine strategiebasierte inhaltliche Evaluation auf Basis der Stanford-Kriterien zur Evaluation von klinischer Lehre [7] für eine formative kompetenzbasierte Simulationsprüfung eines telemedizinischen ersten Arbeitstages im Krankenhaus [8] durchgeführt. In den Jahren 2020 bis 2023 nahmen insgesamt 879 Studierende an der formativen Simulationsprüfung teil. Darunter waren 707 Studierende im PJ und 172 Studierende vor dem PJ (Semester 6 bis 12). Es haben außerdem 303 Studierende wiederholt am Simulationsformat teilgenommen. Die Teilnehmenden waren im Mittel 26,8±3,6 Jahre alt und zu 66,6% weiblich. Die Teilnahme war freiwillig und die Plätze wurden nach Eingang der Anmeldungen vergeben.

2.1. Formative Simulationsprüfung

Die formative Simulationsprüfung eines ersten Arbeitstages im Krankenhaus basiert auf einem validierten Simulationsformat [4], das seit 2020 als telemedizinisches Format durchgeführt wird [8] und drei Basis-Phasen umfasst:

- Sprechstunde,

- Fallbearbeitung,

- Fallvorstellung und -besprechung in oberärztlicher Gesprächsrunde.

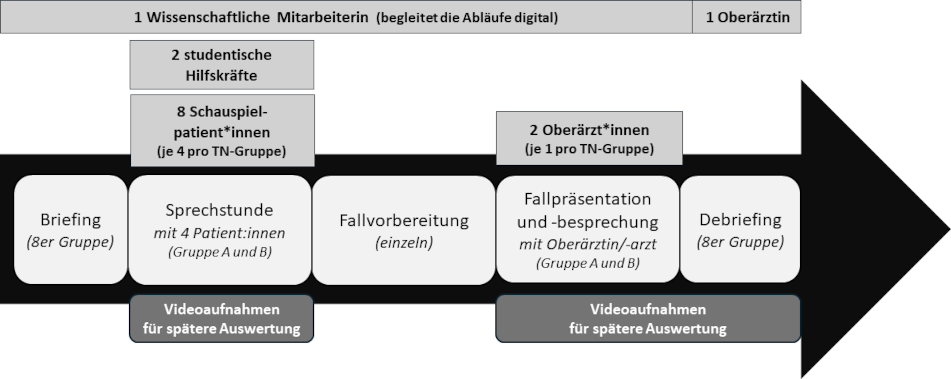

Die Umwandlung des Formates von der Durchführung in Präsenz auf eine digitale Umsetzung hatte auf den grundsätzlichen Ablauf keinen Einfluss. Alle Phasen werden vom Aufbau identisch durchgeführt. Die Patient*innen Gespräche und Besprechungen in der Gruppe finden nun digital statt. Die einzigen Unterschiede sind, dass die Studierende von zu Hause teilnehmen, also physisch „alleine“ sind, und der Aspekt der telemedizinischen Betreuung von Patient*innen nun Teil der Simulation geworden ist (siehe Abbildung 1 [Abb. 1]).

Abbildung 1: Ablauf des Simulationsformats mit Personalressourcen (TN=Teilnehmende)

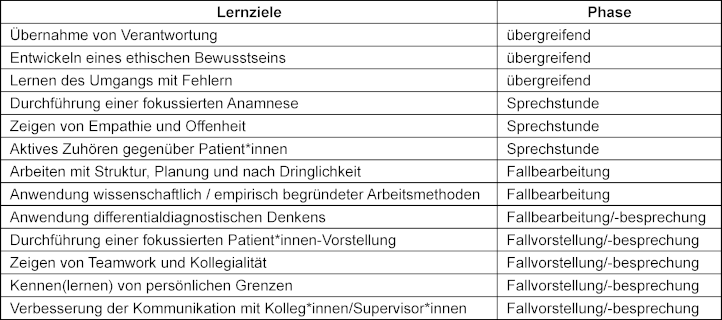

Die Simulation wurde auf Basis der zehn wichtigsten, konsentierten Kompetenzfacetten für ärztliche Berufsanfänger*innen [9] etabliert. Einige der Kompetenzfacetten stellen simulationsübergreifende Lernziele dar, während andere spezifische Lernziele in den drei Basis-Phasen beinhalten (siehe Tabelle 1 [Tab. 1]). Die weiteren praktischen Lernziele des Simulationsformates sind das Üben fokussierter Anamnese und Patient*innen-Vorstellung sowie des differentialdiagnostischen Denkens.

Tabelle 1: Lernziele in verschiedenen Kompetenzbereichen nach Simulationsphasen

Für die Sprechstunde wurde ein Bewertungsinstrument für medizinische Kommunikation und interpersonelle Fähigkeiten (ComCare) validiert [10], welches von den Simulationspatient*innen für das Feedback an die Studierenden verwendet wurde. Für die Managementphase wurde eine digitale Dokumentationsmöglichkeit erstellt. Für das Übergabegespräch bzw. die Fallpräsentation konnten die Teilnehmenden verschiedene Befunde der Patient*innen einsehen. Anschließend erfolgte eine digitale Fallbesprechung in Vierergruppen mit jeweils einem Oberarzt bzw. einer Oberärztin, sodass aus Studierendensicht alle vier Krankheitsbilder der Patient*innen, die sie in der Sprechstunde gesehen hatten, besprochen wurden.

Die im Sinne der freiwilligen Praxis („Deliberate Practice“ [11]) angebotene formative Simulationsprüfung wird bei der Zielgruppe der Studierenden mit der Möglichkeit, die eigenen Kompetenzen zu überprüfen, beworben. Hierbei wird auf den Lernzugewinn im Sinne des Erwerbs „adaptiver Expertise“ [12] hingewiesen. Für die Teilnehmenden steht damit nicht der Charakter einer Prüfung im Fokus, sondern das Simulationsformat als Training bzw. Übung.

2.2. Evaluationsansatz

Es wurde jeweils zum Ende der Simulation eine Evaluation durchgeführt. Der Evaluationsfragebogen, der mit LimeSurvey (Version 6.5) erstellt wurde, umfasst neben geschlossenen Fragen (1 „trifft gar nicht zu“ bis 5 „trifft voll und ganz zu“) und offenen Freitextfragen auch eine Gesamtbewertung des Simulationsformats in Form einer Schulnote.

Die Freitextfelder bieten die Möglichkeit, Angaben zu den folgenden Aspekten zu machen:

- Aspekte, die im Training besonders gut gefallen haben

- Gründe für das Weiterempfehlen des Trainings

- Freie Rückmeldemöglichkeit für alle weiteren Gedanken zum Training

- Gründe für eine wiederholte Teilnahme (für die Personen, die mehrfach teilgenommen haben)

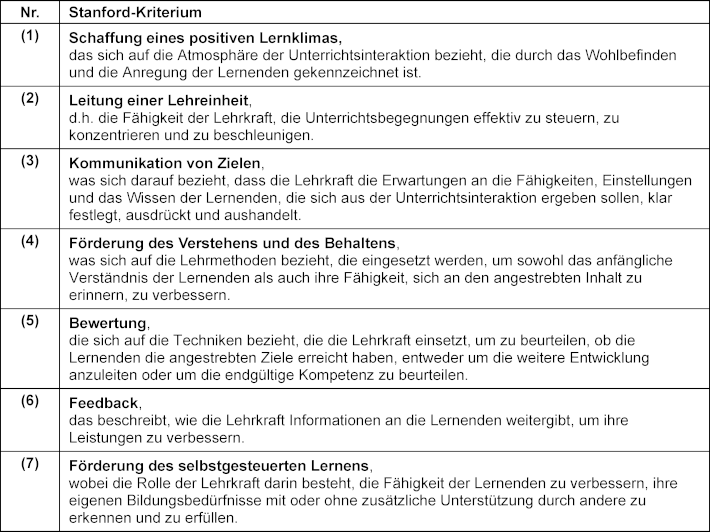

So kann herausgefunden werden, welche Aspekte den Teilnehmenden besonders wichtig sind, weil sie diese von selbst ansprechen und nicht nur zu geschlossen vorgegebenen Aspekten befragt werden. Die geschlossenen Fragen zu Aspekten der Lehrqualität vervollständigen die Evaluation. Diese lassen sich zusammen mit den offenen Antworten anhand der sieben Standford-Kriterien zur Evaluation von klinischer Lehre [7] auswerten. Litzelman et al. [13] haben die sieben Stanford-Kriterien, wie in Tabelle 2 [Tab. 2] dargestellt, ausformuliert.

Tabelle 2: Ausformulierung der Stanford-Kriterien nach Litzelman et al. [13]

Die Rücklaufquote der Evaluation lag bei 98,7%. Es machten 603 Teilnehmende Angaben in den Freitextfeldern. Die insgesamt 918 Freitext-Kommentare wurden mit MAXQDA Analytics Pro (Version 22.6.0) ausgewertet. Dabei wurden die Kommentare entsprechend ihrer Inhalte den induktiv entstandenen Kategorien zugeteilt. Diese wurden wiederum den Stanford-Kriterien guter klinischer Lehre zugeordnet und dann weiter diskutiert, um die Lernziele zu überprüfen. Die einzelnen Kommentare adressieren in der Regel mehrere Aussagen, so dass sie zum Teil jeweils mehreren inhaltlichen Kategorien zugeordnet wurden, wodurch die addierten Prozentangaben in Tabelle 3 [Tab. 3] mehr als 100% ergeben. Die Anzahl pro Kategorie wurde jeweils in Bezug zu der Gesamtanzahl der Freitextkommentare gesetzt, um einen Eindruck davon zu bekommen, welche Aspekte welche Relevanz für die Teilnehmenden hatten.

Tabelle 3: Evaluationsergebnisse nach Kategorien und Häufigkeit

3. Ergebnisse

In Tabelle 3 [Tab. 3] sind die Freitexte nach den induktiv entstandenen inhaltlichen Kategorien „Qualität des Trainings“, „Praktische Lerninhalte“, „Trainingsphasen“, „Lernklima“, „Danksagung“, „Lernaspekte“, „Aspekte zu den Patient*innen“, „Lob der Organisation“ und „Feedback erhalten“ dargestellt. Allgemein zeigt sich, dass die Qualität des Trainings, die praktischen Lerninhalte und Aspekte der einzelnen Trainingsphasen insgesamt die wichtigsten Themen bei der Bewertung für die Studierenden sind. Aspekte der oberärztlichen Fallbesprechung werden am häufigsten genannt (40,5%), wenn es darum geht zu beschreiben, was am besten gefallen hat. Das Üben und Lernen von klinischem Denken und Differentialdiagnostik, ein wesentliches Lernziel der Simulation, ist der häufigste Grund, weshalb die Teilnehmenden das Simulationsformat weiterempfehlen möchten (43,7%). Aspekte des Lernens und Wissenserwerbs bzw. -abgleichs, die wichtige Aspekte des selbstgesteuerten Lernens darstellen, sind am häufigsten genannte Gründe für die wiederholte Teilnahme (34,6%).

Die Teilnehmenden bewerten das Lehrformat insgesamt im Mittel mit der Schulnote 1,26±,45. Im Folgenden werden die Evaluationsergebnisse entsprechend der oben aufgeführten sieben Stanford-Kriterien strukturiert und näher betrachtet:

3.1. Lernklima (Kriterium 1)

Von den Teilnehmenden (S1-S23) wird ein sehr positives Lernklima in der Simulation beschrieben, was offenbar zu positiven Lernerfolgen führt und zu einer wiederholten Teilnahme angeregt hat. Insgesamt 21,1% der Evaluationskommentare adressieren die positiven Aspekte des erlebten Lernklimas. Der Mehrwert liegt dabei darin:

Die Studierenden berichten zwar zum Teil von anfänglichen Ängsten und ihrer Sorge der Überforderung o.ä., erleben in der Simulation jedoch einen „geschützten Rahmen“ (S2), in dem ein Sich-Ausprobieren möglich ist und Lernerfolge erzielt werden:

Die Teilnehmenden loben darüber hinaus die angenehme Atmosphäre, die das Fehlermachen erlaubt:

Es wird außerdem vermehrt der Spaßfaktor betont. Explizit benennen diesen Aspekt 69 Kommentare. Es zeigt sich auch die Kombination von Spaß beim klinischen Arbeiten in der Simulation mit der Wahrnehmung als anspruchsvoller Kurs:

3.2. Leitung (Kriterium 2)

Die Teilnehmenden geben an, dass die Lehrpersonen die Inhalte der Veranstaltung gut und zielgruppengerecht vermitteln konnten (4,70±,51). In den Freitexten wird vielfach die gute Betreuung in der Simulation gelobt. Als Teilaspekte der Bewertung zum didaktischen Konzept, das auch vermehrt bei den Kommentaren, was besonders gefallen hat, benannt wird, finden sich Aspekte der allgemeinen Strukturierung und der Zeitstrukturierung, die zum Stanford-Kriterium „Leitung“ zählen. Durch die konzeptionelle Planung der Simulation kann diese strukturell effektiv gesteuert und die wichtigen Lernaspekte können fokussiert-adressiert sowie konzentriert aufgenommen werden.

Durch Förderung und Fordern können die Lehrpersonen die Simulation dem Lerntempo der Studierenden anpassen. Dies wird explizit in der abschließenden Fallbesprechung gemacht, bzgl. der die oberärztliche Betreuung sehr positiv beschrieben wird:

Positiv wird auch die Möglichkeit des selbständigen Arbeitens vermehrt beschrieben:

3.3. Kommunikation von Zielen (Kriterium 3)

Die Teilnehmenden bewerten die Veranstaltung als didaktisch gut aufbereitet (4,80±,44) und beschreiben das Erreichen von Lernzielen, die in den verschiedenen Phasen der Simulation impliziert waren:

3.4. Förderung des Verstehens bzw. Behaltens und selbstgesteuerten Lernens (Kriterien 4 und 7)

Neben dem Erreichen der Ziele beschreiben die Teilnehmenden deutlich die gelungene Förderung des Verstehens und Behaltens der Lerninhalte:

Es zeigen sich auch konkrete Lernerfahrungen, die zum weiteren, selbstgesteuerten Lernen anregen:

Auch das empfundene Verantwortungsgefühl (3,99±,91) bildet eine wichtige Lernerfahrung, die zunächst im geschützten Raum der Simulation auf den klinischen Alltag vorbereiten kann. Außerdem scheint die Simulation auch dazu beizutragen, die eigene „Comfort Zone“ zu verlassen (S17) und Selbstvertrauen zu gewinnen, was einen wichtigen Aspekt im klinischen Arbeiten für die Verantwortungsübernahme und das Arbeiten im Team darstellt:

Die Simulation ermöglicht, wie oben dargestellt, die eigenen Wissenslücken, Lernbedarfe und Verbesserungspotenziale selbst wahrzunehmen und so ein nachhaltiges Lernen und die eigene Steuerung des Lernens zu unterstützen:

Dabei zeigen sich wichtige Aspekte der Selbstregulation, die aus der Selbstreflexion entstehen und so selbstgesteuertes Lernen aktivieren:

3.5. Bewertung und Feedback (Kriterien 5 und 6)

Das selbstgesteuerte Lernen wurde ebenfalls durch die Bewertung und das Feedback in der Simulation angeregt. Die Teilnehmenden erhielten im bzw. nach der Simulation sowohl quantitative Bewertungen als auch mündliches bzw. schriftliches Feedback. Sowohl das Feedback der Lehrenden (OÄ) als auch das der Schauspielpatient*innen (4,87±,36 bzw. 4,72±,61) wird als sehr wertvoll von den Teilnehmenden wahrgenommen. Viele betonen darüber hinaus die Wichtigkeit von Feedback in ihren Kommentaren. Hierbei werden das fachliche Feedback mit „guten Tipps“ fürs klinische Denken sehr geschätzt und die Hinweise der Simulationspatient*innen für die weitere Entwicklung der kommunikativen Fähigkeiten als hilfreich angesehen.

4. Diskussion

Die Ergebnisse zeigen eine sehr positive Annahme des Simulationsformates mit deutlichen Hinweisen für die Umsetzung guter klinischer Lehre nach den Stanford-Kriterien und die Erfüllung der Lernziele. Die positive Wahrnehmung der Möglichkeit selbständig zu arbeiten ist eine wichtige Lernerfahrung für die Teilnehmenden, besonders unter dem Aspekt, dass dies im Studium und auch im PJ in dieser Form eher selten erlebt wird. Hierin zeigt sich außerdem die erfolgreiche Integration des übergreifenden Lernzieles der Übernahme von Verantwortung. Der von den Teilnehmenden benannte Raum für Selbständigkeit, der zwar als „frei“ empfunden, aber dennoch geleitet im Sinne von „Guided Discovery“ [14] in der Simulation funktioniert, zeigt den Aspekt von erfolgreicher Leitung (Kriterium 2) und wird von den Teilnehmenden positiv wahrgenommen. In diesem angeleiteten Entdecken setzen sich die Teilnehmenden mit Problemen auseinander (Anamnesegespräche und Fallbearbeitung) und erhalten von den Lehrenden Hinweise (Untersuchungsbefunde, Unterstützung in der Fallbesprechung) sowie Feedback (in der Fallbesprechung und nach der Simulation). Dieser Ansatz ermöglicht somit eine durch die Lehrenden geleitete studentische Reflexion des eigenen Arbeitsprozesses [15]. Dies erlaubt den Teilnehmenden, sich in eine sogenannte produktive Anstrengung zu begeben, also eine Herausforderung, bei der auch Fehler gemacht werden dürfen und für die die stärkste Assoziation mit Lernerfolg gezeigt werden konnte [16]. Das als positiv erlebte Lernklima (Kriterium 1) ist dabei essenzieller Bestandteil des Erfolgs von Lernen [17]. Der darin erlebte Spaß sorgt nicht nur dafür, dass das Lernklima positiv wahrgenommen wird, sondern kann außerdem dazu beitragen, besser zu lernen [18], [19]. Die als angenehm erlebte Lernatmosphäre, die das Fehlermachen erlaubt, zeigt das Potential, die Kompetenz ‚Umgang mit Fehlern‘ in der Simulation zu entwickeln. Die Kombination aus Spaß, Lernanforderung und positivem Lernklima bilden in Kombination mit dem Feedback ein gutes Gleichgewicht in der gesamten Lernatmosphäre der Simulation, was zu einer positiven Lernerfahrung und zum Erreichen von Lernzielen im Sinne des Erwerbs „adaptiver Expertise“ führt [12]. Neugewonnene Motivation und die Berichte der wiederholt teilnehmenden Personen zeigen, dass die Lerninhalte nachhaltig internalisiert werden und somit eine Beständigkeit aufweisen, die das Lernen, Verstehen und Behalten prägen (Kriterium 4) und die Studierenden die Möglichkeit zum selbstgesteuerten Lernen (Kriterium 7) nachhaltig nutzen.

Da die Teilnahme freiwillig war, ist nicht auszuschließen, dass besonders motivierte Studierende mit einer positiven Grundeinstellung zum Simulationsformat teilgenommen haben, was einen Einfluss auf die Evaluationsergebnisse genommen haben könnte. Außerdem fokussiert die Evaluation auf die Stanford-Kriterien, was dazu geführt haben könnte, dass andere ebenfalls wichtige Teilaspekte nicht ausreichend beleuchtet wurden. Andererseits konnten die Evaluationsdaten von 868 Teilnehmenden mit Hilfe dieser Stanford-Kriterien standardisiert ausgewertet werden. Aus den Evaluationsergebnissen lassen sich, wie für Evaluationen gefordert [6], verschiedene Konsequenzen auf struktureller und prozeduraler Ebene des Simulationsformats ableiten. Bereits während des Projektes wurden Anpassungen des Formats vorgenommen, die auf die Evaluationsergebnisse zurückzuführen sind. Beispielsweise wird seit 2022 eine zusätzliche Trainingsphase durchgeführt, in der die Studierenden die Fälle in der Kleingruppe kollegial vorbesprechen. Dies entspricht dem Arbeitsalltag und führt zu einem besseren Erreichen der Lernziele. Weitere Anpassungsmöglichkeiten der Simulation werden auf Basis der Evaluation fortlaufend geprüft.

5. Schlussfolgerung

Auf Basis der standardisiert durchgeführten Evaluation kann die Integration des hier beschriebenen Simulationsformats ins Curriculum empfohlen werden. Eine Weiterentwicklung des Formates ist ebenfalls auf dieser Grundlage möglich. Außerdem kann das Simulationsformat longitudinal eingesetzt und unter diesem Aspekt im Verlauf evaluiert werden.

Anmerkungen

Ethik

Dieses Projekt wurde in Übereinstimmung mit der Erklärung von Helsinki durchgeführt. Die Ethik-Kommission der Ärztekammer Hamburg genehmigte dieses Projekt (PV3649). Die Teilnahme an der formativen Simulationsprüfung war freiwillig. Es liegen schriftliche Einwilligungserklärungen vor.

Finanzierung

Dieses Projekt wurde durch die Joachim Herz Stiftung und die Medizinische Fakultät der Universität Hamburg unterstützt.

ORCIDs der Autorinnen

- Sarah Prediger: [0000-0001-5483-1983]

- Sigrid Harendza: [0000-0002-7920-8431]

Danksagung

Wir danken allen Teilnehmenden für ihre Beteiligung an der Evaluation.

Interessenkonflikt

Die Autorinnen erklären, dass sie keinen Interessenkonflikt im Zusammenhang mit diesem Artikel haben.

Literatur

[1] Hager P, Gonczi A. What is competence? Med Teach. 1996;18(1):15-18. DOI: 10.3109/01421599609040255[2] Schafer H, van der Blij M, Boon J, van Lieshout H, Schrijen JM. Competentieprofielen: over schillen en knoppen. Fontys. 2002. Zugänglich unter/available from: https://surfsharekit.nl/public/cc2bbd44-4ee4-4199-b6b5-507f4f74009d

[3] Bundesministerium für Gesundheit. Referentenentwurf des Bundesministeriums für Gesundheit. Verordnung zur Neuregelung der ärztlichen Ausbildung. Berlin: Bundesministerium für Gesundheit; 2023. Zugänglich unter/available from: https://www.bundesgesundheitsministerium.de/fileadmin/Dateien/3_Downloads/Gesetze_und_Verordnungen/GuV/A/Referentenentwurf_AEApprO.pdf

[4] Prediger S, Schick K, Fincke F, Fürstenberg S, Oubaid V, Kadmon M, Berberat PO, Harendza S. Validation of a competence-based assessment of medical students’ performance in the physician’s role. BMC Med Educ. 2020;20(1):6. DOI: 10.1186/s12909-019-1919-x

[5] Gibson KA, Boyle P, Black DA, Cunningham M, Grimm MC, McNeil HP. Enhancing evaluation in an undergraduate medical education program. Acad Med. 2008;83(8):787-793. DOI: 10.1097/ACM.0b013e31817eb8ab

[6] Haverkamp N, Barth J, Schmidt D, Dahmen U, Keis O, Raupach T. Position statement of the GMA committee “teaching evaluation”. GMS J Med Educ. 2024;41(2):Doc19. DOI: 10.3205/ZMA001674

[7] Stanford Faculty Development Center for Medical Teachers (SFDC). Core curriculum for clinical teaching seminars. Standford (CA): Standford Faculty Development Center; 2023. Zugänglich unter/available from: https://med.stanford.edu/sfdc/clinical_teaching.html

[8] Harendza S, Gärtner J, Zelesniack E, Prediger S. Evaluation of a telemedicine-based training for final-year medical students including simulated patient consultations, documentation, and case presentation. GMS J Med Educ. 2020;37(7):Doc94. DOI: 10.3205/zma001387

[9] Fürstenberg S, Schick K, Deppermann J, Prediger S, Berberat PO, Kadmon M, Harendza S. Competencies for first year residents - physicians’ views from medical schools with different undergraduate curricula. BMC Med Educ. 2017;17(1):154. DOI: 10.1186/s12909-017-0998-9

[10] Gärtner J, Bußenius L, Schick K, Prediger S, Kadmon M, Berberat PO, Harendza S. Validation of the ComCare index for rater-based assessment of medical communication and interpersonal skills. Patient Educ Couns. 2022;105(4):1004-1008. DOI: 10.1016/j.pec.2021.07.051

[11] Moulaert V, Verwijnen MG, Rikers R, Scherpbier AJ. The effects of deliberate practice in undergraduate medical education. Med Educ. 2004;38(10):1044-1052. DOI: 10.1111/j.1365-2929.2004.01954.x

[12] Clarke SO, Ilgen JS, Regehr G. Fostering adaptive expertise through simulation. Acad Med. 2023;98(9):994-1001. DOI: 10.1097/ACM.0000000000005257

[13] Litzelman DK, Stratos GA, Marriott DJ, Skeff KM. Factorial validation of a widely disseminated educational framework for evaluating clinical teachers. Acad Med. 1998;73(6):688-695. DOI: 10.1097/00001888-199806000-00016

[14] Mayer RE. Should there be a three-strikes rule against pure discovery learning? The case for guided methods of instruction. Am Psychol. 2004;59(1):14-19. DOI: 10.1037/0003-066X.59.1.14

[15] Kua J, Lim WS, Teo W, Edwards RA. A scoping review of adaptive expertise in education. Med Teach. 2021;43(3):347-355. DOI: 10.1080/0142159X.2020.1851020

[16] Kapur M. Examining productive failure, productive success, unproductive failure, and unproductive success in learning. Educ Psychol. 2016;51(2):289-299. DOI: 10.1080/00461520.2016.1155457

[17] Isba R. Creating the learning environment. In: Walsh K, editor. Oxford textbook of medical education. Oxford: Oxford University Press; 2016. p.100-110. DOI: 10.1093/med/9780199652679.003.0009

[18] Gifford H, Varatharaj A. The ELEPHANT criteria in medical education: Can medical education be fun? Med Teach. 2010;32(3):195-197. DOI: 10.3109/01421591003614866

[19] Toufan N, Omid A, Haghani F. The double-edged sword of emotions in medical education: A scoping review. J Educ Health Promot. 2023;12:52. DOI: 10.4103/jehp.jehp_644_21