[MaReS (Magdeburger Reflexionsskala) – Entwicklung einer Feedback-Methode für reflektierendes Schreiben in der Ausbildung von Gesundheitsberufen: Eine Pilotstudie in der Veterinärmedizin]

Sabine Ramspott 1Ulrike Sonntag 2

Anja Härtl 3

Stefan Rüttermann 4

Doris Roller 5

Marianne Giesler 6

Linn Hempel 7

1 Trillium GmbH Medizinischer Fachverlag, Grafrath, Deutschland

2 Charité – Universitätsmedizin Berlin, Institut für Allgemeinmedizin, Berlin, Deutschland

3 Universitätsklinikum Augsburg, Stabsstelle für Hygiene und Umweltmedizin, Augsburg, Deutschland

4 Institut für medizinische und pharmazeutische Prüfungsfragen (IMPP), Mainz, Deutschland

5 Ruprecht-Karls-Universität Heidelberg, Zentrum für Psychosoziale Medizin, Institut für Medizinische Psychologie, Heidelberg, Deutschland

6 Freiburg/Br., Deutschland

7 Martin-Luther-Universität Halle-Wittenberg, Medizinische Fakultät, Dorothea Erxleben Lernzentrum, Halle/Saale, Deutschland

Zusammenfassung

Zielsetzung: Das Ziel der Studie war die Entwicklung eines Bewertungsinstruments, mit dem Studierenden konstruktives Feedback gegeben werden kann sowie Belege für die Konstruktvalidität des Instruments zu sammeln.

Methodik: Die Magdeburger Reflexionsskala (MaReS) wurde in einem iterativen Prozess im Anschluss an einen Workshop zum Thema Reflexion durch eine Arbeitsgruppe eines Ausschusses der „Gesellschaft für Medizinische Ausbildung (GMA)“ im Juni 2016 entwickelt.

25 Berichte von 13 Studierenden der Veterinärmedizin wurden in zwei Durchgängen (13 und zwölf Berichte) von drei unabhängigen Beurteilenden mit MaReS und von zwei Beurteilenden mit dem Instrument REFLECT bewertet. Die Validität wurde anhand der folgenden Komponenten der Konstruktvalidität von Messick ermittelt: Inhalt (Entwickeln des Instruments), Antwortprozess (Kodierleitfaden, Schulung der Beurteilenden, Bewertungsdauer, Evaluation durch Studierende), interne Struktur (Inter-Rater-Reliabilität, IRR) und Beziehung zu anderen Variablen (Vergleich der Bewertung mit Instrument REFLECT und einer globalen Bewertungsskala).

Ergebnisse: Das analytische Instrument umfasst zwölf Items, die auf einer dreistufigen Skala bewertet werden. Die Autor:innen entwickelten eine Aufgabenstellung mit Leitfragen für die Studierenden sowie einen Kodierleitfaden. Die Ergebnisse für das freie marginale Kappa der Items von MaReS reichten von -0,08 bis 0,77 für die erste Gruppe von Reflexionsberichten und von 0,13 bis 0,75 für die zweite Gruppe. Die Korrelationen zwischen MaReS und REFLECT waren positiv (erster Durchlauf: r=0,92 (p<0,001); zweiter Durchlauf: r=0,29 (p=0,37)).

Schlussfolgerung: MaReS kann ein nützliches Instrument sein, um das reflektierende Schreiben von Studierenden in der Ausbildung von Gesundheitsberufen sowohl anzuleiten als auch strukturiertes Feedback zu geben. Die Verwendung von weiteren Berichten zur Schulung der Beurteilenden und mehr Trainingszyklen würden vermutlich zu höheren IRR führen.

Schlüsselwörter

Reflexion, reflektierendes Schreiben, analytisches Bewertungsinstrument, Validität, Feedback

1. Einleitung und Zielsetzung

1.1. Reflexion in der Ausbildung von Gesundheitsberufen

Um die Patientenversorgung zu verbessern, wurden verschiedene Rollen, die Mediziner*innen [16] erfüllen müssen, sowie eine Reihe von Domänen für die tierärztliche Praxis [5] definiert. Um den Anforderungen dieser Rollen bzw. Domänen gerecht zu werden, müssen Fachkräfte im Gesundheitswesen während ihres Studiums zahlreiche entsprechende Kompetenzen erwerben [https://www.avma.org/education/center-for-veterinary-accreditation/accreditation-policies-and-procedures-avma-council-education-coe], [13], [16], [36], [45]. Da die Anforderungen und das Wissen stetig wachsen, wird das Arbeitsumfeld der Fachkräfte immer komplexer. Um eine zeitgemäße Gesundheitsversorgung zu gewährleisten, müssen Mediziner*innen und Tiermediziner*innen lebenslang lernen, wobei die Fähigkeit zur Reflexion des eigenen Handelns ein wesentlicher Bestandteil ist [29]. Reflexion wurde bereits in der Aufklärung (vgl. 18. Jh. Kant, Fries u. a.) als wesentliches Mittel der Erkenntnis angesehen und u. a. als „innere Einkehr“ beschrieben [17], [25]. In der heutigen Literatur wird Reflexion u. a. als „in-depth consideration of events or situations: the people involved, what they experienced, and how they felt about it“ [6] beschrieben.

Reflexion unterstützt somit auch den Prozess der beruflichen Identitätsbildung, einen wichtigen Entwicklungsprozess für Personen in den Gesundheitsberufen [9]. Darüber hinaus zeigt sich, dass Reflexion die Resilienz zu fördern [56] und Stress zu reduzieren scheint [33]. Diese Erkenntnisse werden auch deswegen relevanter, da das Wohlbefinden von Mediziner*innen und Tiermediziner*innen in den letzten Jahren immer mehr an Bedeutung gewonnen hat [19], [31], [32], [55], [60].

Die Fähigkeit zur Reflexion kann als Teil eines Lernprozesses [54] entwickelt und durch verschiedene Aktivitäten gefördert werden: Reflektierendes Schreiben ist in der medizinischen Ausbildung weit verbreitet [27], [28], [46], [53], [58].

Andere Aktivitäten, die das Reflektieren fördern, sind Gruppendiskussionen [7], [33], Online-Foren [35], „digital Storytelling“ [52] und gemeinsames Zeichnen [34].

„Schreiben als Methode“ ist nachweisbar wirksam [48]. Indem Menschen eine wahrgenommene Situation aufschreiben, werden sie sich des Geschehenen gewahr und trainieren zusätzlich ihre Ausdrucksfähigkeit. Dies wirkt sich auf das Denken, Fühlen und Handeln aus. Am meisten profitieren Menschen, die im Alltag wenig Gelegenheit zur Selbstoffenbarung haben, denen das Erkennen und Benennen von Gefühlen schwerfällt und die im Schreiben Perspektiven zu ihren festen Denkmustern ausprobieren können [54].

Um Reflexion zu fördern, kann Feedback ein äußerst relevantes und wirkungsvolles Instrument sein. Ein systematisches Review zeigte jedoch, dass in den meisten Studien, die Feedback als Element ihrer Intervention zur Förderung der Reflexion einsetzten, die Methoden und Feedbackdetails unklar blieben [55]. Nur eine der Studien beschrieb das Protokoll, das für die Bereitstellung von Feedback verwendet wurde [3].

Im deutschsprachigen Raum gibt es viele große medizinische und veterinärmedizinische Fakultäten mit bis zu 870 Studienanfänger*innen (z. B. Ludwig-Maximilians-Universität München, Deutschland). Reflektierendes Schreiben scheint ein ideales Mittel zu sein, um eine große Anzahl von Studierenden in Reflexionsprozesse zu involvieren. Es ist jedoch ressourcenintensiv, Reflexion zu lehren und einer großen Anzahl von Studierenden Feedback zu ihren Texten zu geben. Ein individuelles schriftliches Feedback ist sehr wahrscheinlich zeitaufwändiger als die Nutzung eines Instruments, mit dem durch Ankreuzen Feedback gegeben werden kann. Somit können entsprechende Bewertungsinstrumente ein geeignetes Mittel sein, um das Geben von Feedback zu vereinfachen. Da der Einsatz von strukturierter Reflexion in der Ausbildung von Gesundheitsberufen in Deutschland, Österreich und der Schweiz (DACH-Region) relativ neu ist, sind Lehrende in der Regel weder in der Vermittlung dieser Kompetenz noch im Geben von Feedback besonders erfahren.

1.2. Bewertungsinstrumente

Zur Bewertung von Leistungen und schriftlichen Reflexionen werden häufig spezielle Instrumente verwendet. Es gibt zwei verschiedene Arten der Bewertung: Bei der ganzheitlichen Bewertung bewerten die Prüfenden den Aufsatz des Studierenden anhand einer vorgegebenen Skala global, während bei der analytischen Bewertung der Aufsatz in einzelne Elemente zerlegt wird, von denen jedes einen Anteil der verfügbaren Note erhält [22]. Ausbildende verwenden in der Regel die ganzheitliche Bewertung für umfangreiche Beurteilungen, da sie als einfach zu handhaben, kostengünstig und genau gilt. Die analytische Bewertung ist für die Lehre nützlich, da die Ergebnisse Lehrenden und Studierenden helfen können, die Stärken und Lernbedürfnisse der Studierenden zu erkennen [24]. Soll die Bewertung eines Reflexionsberichts als formative Beurteilung verwendet werden, scheint der analytische Ansatz besser geeignet.

Lehrende in der Medizin haben mehrere holistische [30], [44], [47], [51], [59], [61] und analytische [10], [11], [57] Instrumente für die formative und/oder summative Bewertung von Reflexionsberichten entwickelt. Reis et al. entwickelten „The Brown Educational Guide to the Analysis of Narrative“ (BEGAN), einen Leitfaden für die Erstellung von schriftlichem Feedback zu Reflexionsberichten von Studierenden [50]. Dieser Leitfaden und die analytischen Instrumente können verwendet werden, um Feedback zu den Reflexionsberichten der Studierenden zu geben. Das Instrument REFLECT umfasst fünf Hauptkriterien (Schreibspektrum, Präsenz, Beschreibung eines Konflikts oder desorientierenden Dilemmas, Beachtung von Emotionen, Analyse und Beimessung von Bedeutung) sowie ein optionales Nebenkriterium (Beachtung der Aufgabenstellung). Diesen Kriterien sind vier Reflexionsstufen zugeordnet (gewohnheitsmäßiges Handeln, überlegtes Handeln oder Introspektion, Reflexion und kritische Reflexion). Wenn die Stufe der kritischen Reflexion erreicht wird, sind die Lernergebnisse auch als transformatives oder bestätigendes Lernen zu definieren [57]. Das Instrument von Devlin et al. umfasst vier Dimensionen (deskriptiv, vergleichend, persönlich und kritisch) mit Fragen, die die Bewertung und das Feedback anleiten [11]. Das Instrument von Devi basiert auf den Indikatoren von Koole [29] zur Beschreibung des Reflexionsprozesses und dem Benotungssystem von Moon [41]. Die Bewertenden benoten die Berichte von A bis F [10]. Bislang konnte kein Bewertungsinstrument für reflektierendes Schreiben im medizinischen Kontext in deutscher Sprache identifiziert werden.

1.3. Leitfäden für reflektierendes Schreiben

Es gibt mehrere Leitfäden für das reflektierende Schreiben in der medizinischen Ausbildung. Im Anhang von Sandars [51] AMEE-Leitfadens finden sich verschiedene Materialien: Beispiele für ein Informationsblatt für Medizinstudierende im Grund- und Aufbaustudium, das auf Moons Handbuch [41] basiert, eine Vorlage für eine strukturierte Reflexion zur Entwicklung einer therapeutischen Beziehung in der beruflichen Praxis nach Johns [23] mit 20 Leitfragen sowie elf Fragen, um die Reflexion zu vertiefen. Aronson et al. [4] entwickelten einen Leitfaden für reflexives Lernen, der aus einem strukturierten Ansatz zur Reflexion auf der Grundlage des SOAP-Formats mit Leitfragen und einem Informationsblatt über Reflexion und Strategien für erfolgreiche Reflexion besteht. Aronson et al. testeten ihr Instrument anhand eines holistischen Bewertungstools [4]. Die Autor*innen dieses Artikels konnten weder ein analytisches Bewertungsinstrument mit dazugehörigen Leitfragen noch einen Leitfaden für Studierende finden.

1.4. Zielsetzung

Ziel der Studie war es, ein deutsches Bewertungsinstrument für die formative Beurteilung von Reflexionsberichten zu entwickeln, das sich an Leitfragen für Studierende orientiert und ihnen wertvolle Rückmeldungen gibt. Die Nutzung des Instruments soll für Lehrende bei der Bewertung von Reflexionsberichten einfach und zeitsparend sein. Darüber hinaus war es das Ziel der Autor*innen, Belege für die Validität des neuen Instruments zu sammeln.

2. Methoden

2.1. Entwicklung des Bewertungsinstruments

Der Ausschuss "Kommunikative und soziale Kompetenzen" (KusK) der Gesellschaft für Medizinische Ausbildung (GMA) veranstaltete im Juni 2016 ein Workshop zum Thema Reflexion, um Möglichkeiten zu erörtern, Reflexion in die Lehre von kommunikativen und sozialen Kompetenzen für Medizin- und Tiermedizinstudierende in Deutschland zu integrieren. Die Teilnehmenden eines Workshops untersuchten drei bestehende Instrumente zur Bewertung von Reflexionsberichten [44], [50], [57]. Basierend auf diesen drei Instrumenten wurde eine erste Version eines Bewertungsinstruments entwickelt.

Nach dem Workshop wurde das Bewertungsinstrument präzisiert, wobei Kooles Modell gemeinsamer Elemente zur Beschreibung eines Reflexionsprozesses [29] als Leitfaden für die Auswahl der Inhalte diente. Hinsichtlich der Struktur und des Wortlauts des Bewertungsinstruments wurde den Empfehlungen von Moskal [43] zur Entwicklung von Bewertungsinstrumenten gefolgt. Das Feedbackinstrument wurde zusammen mit einer passenden Aufgabenstellung, Leitfragen für Studierende sowie einem Kodierleitfaden in einem iterativen Prozess entwickelt. Nach mehreren Überarbeitungen und einem ersten Konsensverfahren durch die Autor*innen dieser Publikation wurden das Instrument, die Aufgabenstellung und die Leitfragen, der Kodierleitfaden und ein Beispiel-Reflexionsbericht an sechs externe Expert*innen geschickt, die sich an medizinischen und veterinärmedizinischen Fakultäten in Deutschland mit Reflexion in der Lehre befassen. Die Expertengruppe setzte sich aus Mediziner*innen, Tiermediziner*innen, Gesundheitswissenschaftler*innen und Psycholog*innen zusammen. Deren Rückmeldungen zum Instrument und seinen Items wurden diskutiert und nach einem Konsens in die neue Version des Instruments eingearbeitet. Das Instrument wurde in Anlehnung an seinen Entstehungsort „Magdeburger Reflexionsskala“ (MaReS) genannt.

2.2. Belege für die Konstruktvalidität

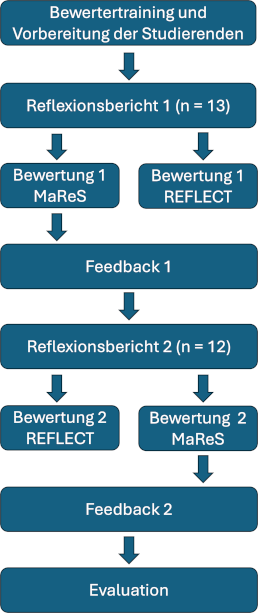

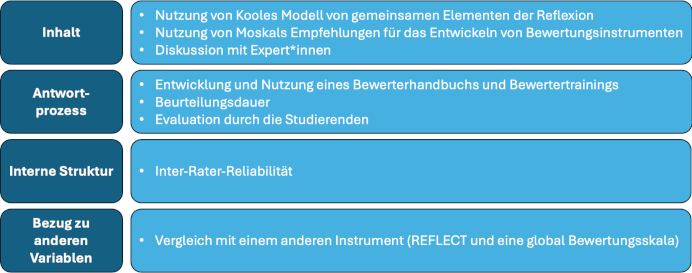

„Validity is an integrated evaluative judgment of the degree to which empirical evidence and theoretical rationales support the adequacy and appropriateness of interpretations and actions based on test scores or other modes of assessment“ [37]. Das Bewertungsinstrument selbst kann nicht für valide (oder nicht valide) erklärt werden, aber es können mehr (oder weniger) Belege für seine Validität gesammelt werden, um die vorgeschlagenen Interpretationen der Bewertungsergebnisse zu unterstützen. Der Kontext, in dem die Belege für die Validität gesammelt werden, ist nach wie vor wichtig: Bewertungsergebnisse sind für einen bestimmten Zweck, eine bestimmte Bedeutung oder Interpretation zu einem bestimmten Zeitpunkt und für eine bestimmte Population, für die Belege für die Validität gesammelt wurden, mehr – oder weniger – gültig [12]. In dieser Studie haben wir Belege für die Validität für die Verwendung des Instruments als formatives Beurteilungsinstrument der Reflexionsfähigkeit in Reflexionsberichten gesammelt. Die Berichte über die tierärztliche Praxis wurden von Tiermedizinstudierenden verfasst, die 2017 an einem Wahlpflichtfach zum Thema Reflexion teilnahmen und von fünf Bewertenden bewertet, die die Studierenden nicht kannten. Jeder Bericht wurde von drei Bewertenden mit dem neu entwickelten Bewertungsinstrument und von zwei mit dem Instrument REFLECT bewertet. Die Autor*innen des vorliegenden Artikels sammelten Belege für die Validität für vier der sechs von Messick [38] aufgeführten Quellen der Konstruktvalidität: Inhalt, Antwortprozess, interne Struktur und Bezug zu anderen Variablen. Abbildung 1 [Abb. 1] zeigt das Studiendesign; Abbildung 2 [Abb. 2] zeigt die für diese Studie ausgewählten Quellen der Belege für die Validität. Im folgenden Abschnitt beschreiben wir die Methoden, die wir zum Sammeln von Belegen für die verschiedenen Quellen der Konstruktvalidität verwendet haben in chronologischer Reihenfolge. Daher wird die Quelle „Antwortprozess“ in diesem Abschnitt aufgeteilt.

Abbildung 1: Studiendesign MaReS

Abbildung 2: Quellen für Belege der Validität von MaReS

2.2.1. Inhalt – Entwicklung des Bewertungsinstruments

Die Art und Weise, wie wir das Instrument entwickelt haben, trägt zum Nachweis der Inhaltsvalidität bei (siehe 2.1.).

2.2.2. Antwortprozess I – Nutzung des Kodierleitfadens und Schulung der Bewertenden

Alle fünf Bewertende nahmen am zweitägigen KusK-Workshop zu Reflexion im Juni 2016 teil. Nach der Entwicklung von MaReS wurde den Bewertenden (us, lh, srü, dr, ah) die endgültige Version des Instruments, die Aufgabenstellung, die Leitfragen und der Kodierleitfaden zur Verfügung gestellt. Sie bewerteten jeweils einzeln und unabhängig den gleichen Beispielbericht. Die Bewertungen wurden verglichen und abweichende Bewertungen wurden mit allen Bewertenden in einer Telefonkonferenz diskutiert. Anschließend einigten sich alle Bewertenden auf eine gemeinsame Vorgehensweise bezüglich der Items. Der Kodierleitfaden wurde entsprechend angepasst.

Der gleiche Ansatz wurde für das Instrument REFLECT [58] verfolgt, das zur Bewertung des Bezugs zu anderen Variablen verwendet wurde (siehe 2.3.). Da hier zu diesem Zeitpunkt kein Kodierleitfaden vorlag, war eine Anpassung nicht erforderlich. Somit wurden die englische Version von REFLECT und die vier Schritte für seine Anwendung verwendet [57].

2.2.3. Interne Struktur – Inter-Rater-Reliabilität und Bezug zu anderen Variablen – Vergleich mit einem anderen Bewertungsinstrument

Die Ethikkommission der LMU München erteilte das Ethikvotum für die Studie (Projektnummer 17-065). Dreizehn Studierende eines Wahlpflichtfachs über Reflexion in der tierärztlichen Praxis schrieben jeweils einen Reflexionsbericht, nachdem sie sechs Stunden Unterricht zu Reflexion im Allgemeinen sowie zu verschiedenen Aktivitäten zur Förderung von Reflexion, einschließlich des reflektierenden Schreibens auf Grundlage von MaReS erhalten hatten. Die Studierenden wurden mit dem Bewertungsinstrument vertraut gemacht. Sie diskutierten verschiedene Beispiele für reflektierendes Schreiben und die Bewertung mit MaReS. Die Aufgabe bestand darin, einen Reflexionsbericht über eine konkrete Situation zu schreiben. Die Studierenden sollten eine Situation aus ihrem Studium oder Beruf wählen, in der sie sich in der Interaktion mit Patient*innen, Patientenbesitzer*innen, Kommiliton*innen oder Lehrenden herausgefordert fühlten. Die 13 Berichte wurden von drei Bewertenden mit MaReS (ah, dr, lh) und von zwei Bewertenden mit REFLECT (us, srü) bewertet. Eine der fünf MaReS-Bewertungen wurde an die Studierenden zurückgemeldet. Anschließend schrieben zwölf der Studierenden einen weiteren Reflexionsbericht, der wiederum von drei Bewertenden (us, srü, lh) mit MaReS und von zwei Bewertenden (ah, dr) mit REFLECT bewertet wurde. Wieder wurde eine der MaReS-Bewertungen an die Studierenden zurückgemeldet. Alle Bewertenden füllten für jeden Bericht eine fünfstufige Gesamtwertung aus. Die Gesamt- und REFLECT-Bewertung wurde nur für Studienzwecke verwendet und nicht an die Studierenden zurückgemeldet.

2.2.4. Antwortprozess II – Bewertungsdauer und Notizen der Bewertenden

Die Bewertenden protokollierten auch die Zeit, die sie für ihre Bewertung benötigten und machten, falls erforderlich, Notizen zu wichtigen Aspekten des Berichts, protokollierten schwierige Items und mögliche neue Ankerbeispiele für den Kodierleitfaden.

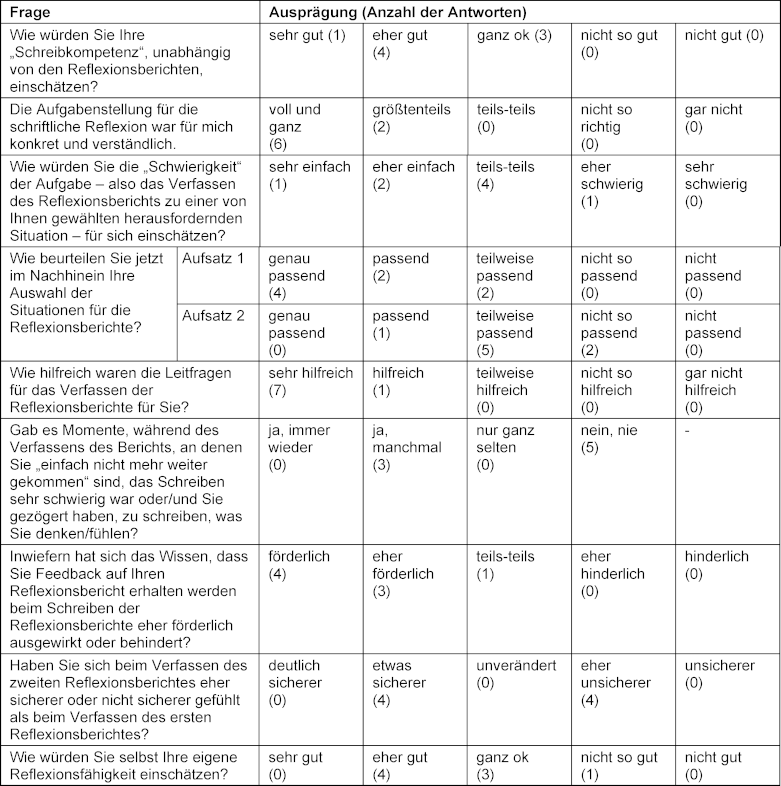

2.2.5. Antwortprozess III – Evaluation durch die Studierenden

Nachdem sie zwei MaReS-Feedbackbögen zu ihren Berichten erhalten hatten, füllten acht Studierende einen Fragebogen aus. Er umfasste fünf allgemeine Fragen zur Reflexion und zum Wahlpflichtfach, sechs Fragen zur Aufgabe und zu den Leitfragen, vier Fragen zu den erhaltenen Rückmeldungen und fünf Fragen zu ihrer Reflexionsfähigkeit und ihren Ansichten über reflektierendes Schreiben.

2.3. Statistische Methoden

Die Bewertungszeit für die Berichte wurde mittels deskriptiver Statistik unter Verwendung von Mittelwerten und Standardabweichung (SD) ausgewertet. Die Inter-Rater-Reliabilität (IRR) wurde mit dem freien marginalen Kappa [49] ermittelt. Die Korrelation zwischen der MaReS-Gesamtnote (Summe der MaReS-Gesamtnote von drei Bewertenden), der REFLECT-Gesamtnote (Summe der REFLECT-Gesamtnote von zwei Bewertenden) und der Gesamtnote (Summe der entsprechenden Gesamtnote von drei Bewertenden für MaReS und von zwei Bewertenden für REFLECT) wurde mit Hilfe des Spearmans Rangkorrelationskoeffizienten ermittelt.

Die Evaluation durch die Studierenden und das Feedback der Bewertenden wurden mittels deskriptiver Statistik (absolute Zahlen) für Fragen mit Antworten auf einer Fünf-Punkte-Skala und mittels Inhaltsanalyse nach Mayring für offene Fragen analysiert.

3. Ergebnisse

3.1. Entwicklung des Bewertungsinstruments

Wir entwickelten eine Schreibaufgabe mit neun Leitfragen sowie ein Instrument mit zwölf Items, die mit einer Drei-Punkte-Skala bewertet wurden (siehe Anhang 1 [Anh. 1]). Der Kodierleitfaden besteht aus einer kurzen Beschreibung, wie der Bericht zu bewerten ist, sowie aus Deskriptoren und Ankerbeispielen für alle Items und konsekutiven Skalen.

3.2. Belege für die Konstruktvalidität

3.2.1. Inhalt – Entwicklung von MaReS

Siehe 3.1.

3.2.2. Antwortprozess – Bewertungsdauer

Die Zeichenzahl (einschließlich Leerzeichen) der Berichte reichte von 2.765 bis 8.488 mit einem Mittelwert von 5.359 Zeichen (SD 1.660). Die durchschnittliche Zeit, die für die Bewertung eines Berichts mit MaReS benötigt wurde, betrug 13,9 Minuten mit einer Standardabweichung von 10,9. Die mittlere Bewertungszeit, d. h. die Zeit, die zum Lesen und Bewerten des Berichts benötigt wurde, variierte stark zwischen den Bewertenden und reichte von durchschnittlich 6,7 Minuten (SD 2,5) bis 28,5 Minuten (SD 13,1). Die mittlere Dauer der REFLECT-Bewertungen betrug 7,8 Minuten mit einer Standardabweichung von 5,2. Die mittleren Bewertungszeiten für die einzelnen Bewertenden reichten von 4,5 Minuten (SD 1,2) bis 14,5 (SD 6,9).

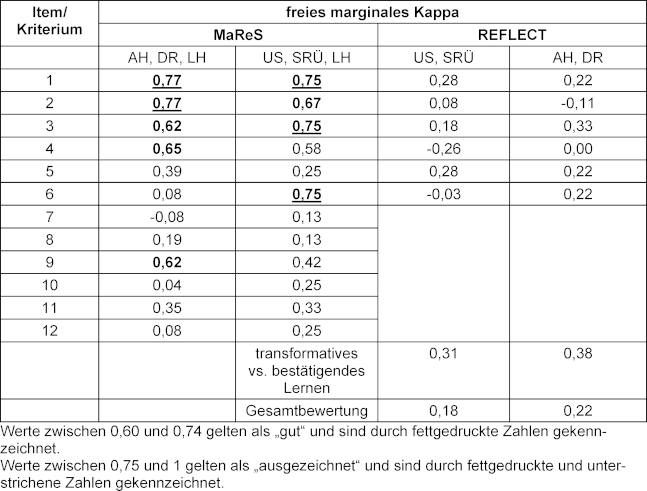

3.2.3. Interne Struktur – Inter-Rater-Reliabilität

Die Ergebnisse für das freie marginale Kappa der MaReS-Items reichten von -0,08 bis 0,77 für die erste Runde von Reflexionsberichten und von 0,13 bis 0,75 für die zweite Runde (siehe Tabelle 1 [Tab. 1]). Die Ergebnisse für das freie marginale Kappa der einzelnen Kriterien von REFLECT reichten von -0,26 bis 0,31 für die erste Runde von Reflexionsberichten und von -0,11 bis 0,38 für die zweite Runde (siehe Tabelle 2 [Tab. 2]). Das freie marginale Kappa für die Gesamtbewertung aller fünf Bewertenden betrug 0,16 für die erste Runde von Berichten und 0,22 für die zweite Runde.

Tabelle 1: Inter-Rater-Reliabilität für MaReS und REFLECT für die verschiedenen Bewertenden

Tabelle 2: Antworten auf die geschlossenen Fragen in den Evaluationen der Studierenden

3.2.4. Bezug zu anderen Variablen – Korrelation der Bewertungen

Für die Berichte 1 bis 13 betrug Spearmans Rangkorrelationskoeffizient für MaReS und die entsprechende Gesamtbewertung der Bewertenden r=0,43 (p=0,14), r=0,92 (p<0,001) für MaReS und REFLECT und r=0,83 (p<0,001) für REFLECT und die Gesamtbewertung.

Für die Berichte 14 bis 25 betrug Spearmans Rangkorrelationskoeffizient für MaReS und die entsprechende Gesamtbewertung der Bewertenden r=0,75 (p=0,005), r=0,29 (p=0,37) für MaReS und REFLECT und r=0,87 (p<0,001) für REFLECT und die entsprechende Gesamtbewertung der Bewertenden.

3.2.5. Antwortprozess – Evaluation durch die Studierenden

Acht Studierende nahmen an der Evaluation teil. Die Ergebnisse der geschlossenen Fragen sind in Tabelle 2 [Tab. 2] dargestellt. Alle Studierenden bewerteten ihre eigene Schreibkompetenz positiv und verstanden die Aufgabe. Die Schwierigkeit der Aufgabe („Verfassen eines Reflexionsberichts über eine selbst gewählte herausfordernde Situation“) wurde von den Studierenden unterschiedlich bewertet. Für den ersten Reflexionsbericht bewerteten die meisten Studierenden ihre eigene Situationsauswahl als „perfekt geeignet“ oder „geeignet“. Für den zweiten Reflexionsbericht wurde die Auswahl von den meisten Studierenden als „teilweise geeignet“ bewertet.

Alle acht Studierenden bewerteten die Leitfragen als „sehr hilfreich“ oder „hilfreich“. Das Wissen, dass sie ein Feedback zu ihrem Reflexionsbericht erhalten werden, wurde von den meisten als „förderlich“ oder „eher förderlich“ bewertet. Beim Verfassen des zweiten Reflexionsberichts fühlte sich die Hälfte der Studierenden „etwas sicherer“, die andere Hälfte „etwas unsicherer“. Die Studierenden bewerteten ihre eigene Reflexionsfähigkeit überwiegend als gut (vier Studierende). Vier Studierende gaben an, dass sie die zweite Reflexion als schwieriger empfanden, weil sie Probleme hatten, eine geeignete Situation für die Reflexion zu finden.

Das strukturierte Feedback wurde von fünf Studierenden positiv bewertet. Sie schrieben, dass das Feedback konstruktiv, hilfreich und nicht wertend war. Gleichzeitig kritisierte eine Person, dass sich das Feedback nur auf den Prozess der Reflexion und nicht auf die Situation bezog. In Bezug auf ihre eigene Reflexionsfähigkeit gaben fünf Studierende an, dass sie ihrer Meinung nach sehr selbstkritisch sind und dies die Reflexion erschwert. Andere Antworten waren: nicht in der Lage zu sein, sofort eine Lösung zu finden; mehr Meinungen von anderen zu benötigen; mehr Zeit zum Nachdenken zu haben.

Die Inhaltsanalyse ergab Folgendes: In ihren Freitextantworten nannten mehrere Studierende Stressbewältigung/-abbau als erwarteten persönlichen Nutzen der Reflexion. Darüber hinaus wurden die persönliche Entwicklung in verschiedenen Bereichen, ein besseres Verständnis für und eine bessere Kommunikation mit anderen (auch privat) sowie Vorteile für künftiges Handeln im Allgemeinen und in Lernsituationen genannt.

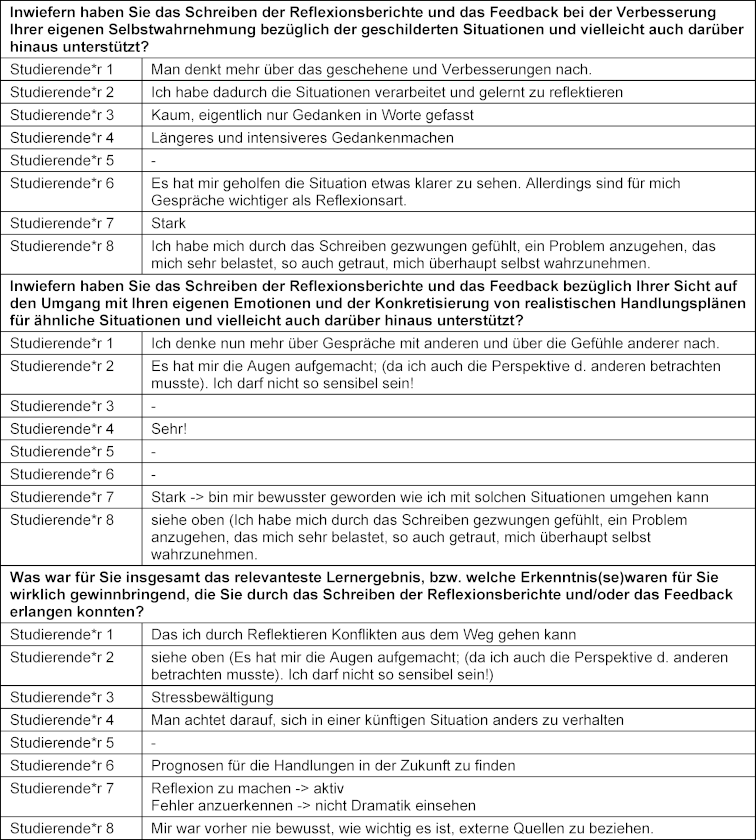

Darüber hinaus sind alle Freitextantworten auf drei Fragen zu den Auswirkungen des Schreibens von Reflexionsberichten und des Feedbacks dazu in Tabelle 3 [Tab. 3] zu finden.

Tabelle 3: Freitext-Antworten über die Auswirkungen des Schreibens und des Feedbacks auf die Reflexionsberichte

4. Diskussion

4.1. Entwicklung des Bewertungsinstruments

Bei MaReS stand die Praktikabilität im Vordergrund. Ziel war es, ein Bewertungsinstrument zu entwickeln, das einfach zu handhaben ist und den Lehrenden Zeit spart. Die schlechtere Inter-Rater-Reliabilität für REFLECT kann ein Hinweis darauf sein, dass MaReS einfacher zu handhaben ist. Die durchschnittliche Bewertungszeit für MaReS war länger als für REFLECT. Dies spiegelt vermutlich die Tatsache wider, dass MaReS eine größere Anzahl von Items (n=12) aufweist als REFLECT (n=6). Unserer Meinung nach sind weniger als 15 Minuten (mittlere Bewertungszeit) zum Lesen und Bewerten eines Reflexionsberichts immer noch als angemessen zu einzuordnen.

4.2 Belege für die Konstruktvalidität

In dieser Studie haben wir Belege für die Validität gesammelt, die sich auf die folgenden Komponenten der Konstruktvalidität beziehen: Inhalt, Antwortprozess, interne Struktur und Bezug zu anderen Variablen [1], [12], [38]. MaReS kann ein geeignetes Instrument für das Lehren von Reflexion und das Feedback zu den Reflexionsberichten der Studierenden sein. Die Kombination von Leitfragen für die schriftliche Reflexion und der Einsatz von MaReS als zeitsparende Möglichkeit, strukturiertes Feedback zu geben, wurde erfolgreich pilotiert.

4.2.1. Inhalt

Belege für die Validität, die auf Testinhalten basieren, ergeben sich aus der Analyse der Beziehung zwischen einem Testinhalt und dem Konstrukt, das es messen soll [1]. Der Inhalt von MaReS (einschließlich der Leitfragen, des Bewertungsinstruments und des Kodierleitfadens) wurde sorgfältig auf Grundlage eines allgemein akzeptierten Modells für das Konzept des Reflexionsprozesses ausgewählt [29]. Wir berücksichtigten auch den Inhalt von drei bestehenden Instrumenten zur Bewertung von Reflexionsberichten [44], [50], [57]. Weitere Belege für die Validität wurden durch die Befragung von sechs externen Expert*innen gewonnen, die den Zusammenhang zwischen Teilen des Tests und dem Konstrukt beurteilen sollten [1]. Ihre Rückmeldungen flossen in die endgültige Version von MaReS ein.

4.2.2. Antwortprozess

Belege für die Validität, die auf dem Antwortprozess basieren, können sowohl den Antwortprozess der Bewertenden als auch den Antwortprozess der Studierenden, die die Aufgabe bearbeiten, umfassen [1].

Um den Bewertungsprozess zu unterstützen, haben wir einen Kodierleitfaden entwickelt, der eine kurze Beschreibung der Bewertung des Berichts sowie Deskriptoren und Ankerbeispiele für alle Items und konsekutiven Skalen enthält. Die Schulung der Bewertenden umfasste einen zweitägigen Workshop zur Reflexion, die Bewertung eines exemplarischen Berichts und eine Diskussion über abweichende Ergebnisse der Bewertung. Am Ende der Diskussion wurde eine Einigung darüber erzielt, wie die Berichte zu bewerten sind.

Obwohl die Inter-Rater-Reliabilität durch die Schulung der Bewertenden verbessert wird, indem man ihnen einen Leitfaden für die Aufzeichnung ihrer Beobachtungen an die Hand gibt [14] und wir in dieser Studie darauf geachtet haben, dass alle Bewertenden verstanden haben, wie die Aufsätze zu bewerten sind, haben wir bei den meisten Items eine schlechte Inter-Rater-Reliabilität festgestellt (siehe 4.2.3.). Dies könnte darauf hindeuten, dass die Schulung der Bewertenden möglicherweise nicht ausreichend war.

Während des Beantwortungsprozesses wurden Daten über die Bewertungsdauer gesammelt. Dies trägt nicht zur Validitätsevidenz bei, sondern soll die Lehrenden in den Gesundheitsberufen, die das reflektierende Schreiben in ihre Curricula aufnehmen möchten, dabei unterstützen, die Durchführbarkeit des Vorhabens zu beurteilen und Ressourcen zu planen.

Zu den Belegen der Validität, die auf dem Antwortprozess der Studierenden basieren, gehört die Vertrautheit der Studierenden mit dem Format [12]. Bevor sie ihre Berichte schrieben, wurden den Studierenden die Leitfragen und das Bewertungsinstrument ausgehändigt. Die Bedeutung der einzelnen Items und die entsprechenden Punktzahlen wurden erklärt. Die Studierenden erhielten zwei Beispielaufsätze und diskutierten die Bewertungen im Unterricht.

Eine weitere Quelle für Belege für die Validität sind verständliche und genaue Beschreibungen und Interpretationen der Bewertungen für die Studierenden [12]. In ihren Bewertungen gaben alle acht Studierenden an, dass die Aufgabe „vollständig“ oder „größtenteils verständlich“ war, und die Leitfragen wurden als „sehr hilfreich“ oder „hilfreich“ bewertet.

4.2.3. Interne Struktur

Nach Fleiss kann eine Inter-Rater-Reliabilität (IRR) von 0,6 und mehr als ausgezeichnet und eine IRR über 0,4 und unter 0,6 als moderat (fair) bis gut angesehen werden. IRRs unter 0,4 werden als schlecht angesehen [15]. Dies bedeutet, dass die IRR für MaReS in unserer Studie nur für die Items 1 bis 4 und Item 9 akzeptabel sind. Betrachtet man den Wortlaut der Items, so scheint der Inhalt, der in den Items 1 bis 4 und 9 (allgemeine Verständlichkeit, Bezug zur Aufgabe, Situationsbeschreibung, Beschreibung der eigenen Emotionen, Auswahl externer Quellen) bewertet wird, konkreter und damit leichter zu bewerten zu sein als der der anderen Items. Die Items 5 bis 8 (Erklärung der eigenen Emotionen, Beschreibung der Perspektive des Gegenübers, Bezug der Perspektive des Gegenübers zur eigenen Perspektive, Einfluss früherer Erfahrungen und Überlegungen) und die Items 10 bis 12 (Bewertung der Situation, Handlungsstrategie, Erwartungen bezüglich der Anwendung der zukünftigen Handlungsstrategie/-en) sind integrale, aber schwierigere Bestandteile der Reflexion. Das Verständnis auf Seiten der Bewertenden scheint bei diesen Items subjektiver zu sein als bei den Items mit einer akzeptablen IRR. Einerseits kann die Erklärung der eigenen Emotionen schwierig sein und die Studierenden könnten das Gefühl haben, dass das Thema zu persönlich ist, um es in einem Reflexionsbericht zu teilen. Andererseits kann die Frage, ob eine Erklärung für Bewertende nachvollziehbar ist, von ihren persönlichen Erfahrungen abhängen. Das Gleiche gilt für den Perspektivwechsel. Die Items 10 bis 12 (Einschätzung der Situation, Handlungsplan) können für die Bewertenden schwierig sein, denn es kann sein, dass die Einschätzung der Situation durch die*den Studierende*n nachvollziehbar oder die Handlungsstrategie konkret ist, der*die Bewertende aber das Gefühl hat, dass sie nicht ausreicht, um eine ähnliche Situation in Zukunft besser zu bewältigen. Dies könnte einige Bewertende dazu veranlassen, niedrigere Bewertungen zu vergeben. Während der Bewertung der Aufsätze machten sich die Bewertenden Notizen zu Punkten, die schwierig zu bewerten waren. Die Analyse dieser Notizen ist nicht Teil dieser Studie, wird aber dazu beitragen, den Kodierleitfaden weiterzuentwickeln und wichtige Aspekte in zukünftigen Schulungen für Bewertende zu berücksichtigen.

Item 7 (die Perspektive des Gegenübers mit der eigenen Perspektive in Beziehung setzen) und Item 8 (Einfluss früherer Erfahrungen und Reflexionen) erhielten ebenfalls vergleichsweise niedrige Bewertungen. Dies könnte darauf hindeuten, dass diese Punkte zu schwierig sind. Im Falle von Item 7 könnten die Studierenden mehr Erklärungen, Beispiele und Training benötigen. Ein Grund für die niedrige Bewertung von Item 8 könnte sein, dass die Studierenden in unserer Studie nicht viel klinische Erfahrung hatten und es für sie schwierig war, auf frühere Erfahrungen oder Reflexionen zurückzugreifen.

Alle IRRs, die sich für das Instrument REFLECT ergeben haben, sind als schlecht zu bewerten. Während drei Studien hohe IRRs für REFLECT ergaben [39], [40], [57], war eine andere Studie ebenfalls nicht in der Lage, diese hohen IRRs zu replizieren. Die Autor*innen der letztgenannten Studie geben an, dass der Unterschied in den Ergebnissen auf den Kontext zurückzuführen sein könnte, in dem die Belege für die Validität erhoben werden (z. B. andere Einrichtung und Studienpopulation) [18]. Da im Falle unserer Studie deutsche Muttersprachler*innen ein englischsprachiges Instrument anwandten, sollten auch Sprachprobleme in Betracht gezogen werden. Es ist zudem wahrscheinlich, dass die Schulung der Bewertenden für REFLECT nicht ausreichend war. Es gibt zwar eine kurze Beschreibung der Anwendung von REFLECT in der Originalarbeit [57], aber die Bewertenden hatten keinen Zugang zu einem Kodierleitfaden. Unsere Schulung der Bewertenden für REFLECT bestand aus der Bewertung und Diskussion von nur einem Beispielaufsatz. Miller-Kuhlman et al. [39] wendeten für die Schulung Ihrer Bewertenden einen solideren Ansatz an: In einem Schulungszyklus verglichen die Bewertenden die Bewertungen und diskutierten Diskrepanzen für mehrere Beispielaufsätze und bewerteten dann weitere Beispiele, bis eine IRR von mindestens 0,8 erreicht war, bevor sie die Daten für ihre Studie sammelten. Diese Schulung für REFLECT erforderte sechs Stunden.

4.2.4. Bezug zu anderen Variablen

Der Vergleich eines neu entwickelten Tests mit einem Test, von dem angenommen wird, dass er das gleiche Konstrukt misst, kann als Beleg zur Bestimmung der Konstruktvalidität herangezogen werden [1]. Die Autor*innen fanden eine positive Korrelation für den Vergleich der MaReS-Bewertungen mit einer globalen Bewertung der Aufsätze und mit dem Instrument REFLECT, das zur Bewertung des Reflexionsniveaus der Studierenden verwendet wird und ein individuelles schriftliches Feedback zur Förderung der Reflexionsfähigkeit geben soll [57]. Für die erste Runde von Aufsätzen zeigten sich starke und signifikante positive Korrelationen [8] für MaReS und REFLECT sowie für REFLECT und die globale Bewertung. Für die zweite Runde zeigten sich starke und signifikante positive Korrelationen für MaReS und das globale Rating sowie für REFLECT und die globale Bewertung. Nahezu moderate und moderat positive (nach Cohen als r von 0,3 [8] definiert) Korrelationen zeigten sich für MaReS/globale Bewertung im ersten Bericht und für MaReS/REFLECT im zweiten Bericht, die beide wahrscheinlich aufgrund der geringen Stichprobengröße nicht signifikant waren. Die Tatsache, dass in der ersten und zweiten Runde unterschiedliche Korrelationen gefunden wurden, könnte durch einen Wechsel der Bewertenden verursacht worden sein. Dennoch deuten die Ergebnisse darauf hin, dass MaReS dasselbe Konstrukt misst wie REFLECT [1], nämlich das Reflexionsniveau der Studierenden.

4.2.5. Evaluationen

In dieser Studie werden Daten für Stufe 1 (Reaktion) des New-World-Kirkpatrick-Modells [26] untersucht. Bei der Betrachtung der Ergebnisse ist zu bedenken, dass die Anzahl der Studierenden, die die Evaluation für MaReS ausgefüllt haben, sehr gering war (n=8) und Schlussfolgerungen mit Vorsicht gezogen werden müssen.

Einige Studierende teilen in ihren Reflexionsberichten sehr persönliche Geschichten und es muss darauf geachtet werden, dass das Feedback zu den Aufsätzen nicht wertend ist [21] und die Gefühle der Studierenden nicht verletzt. Der Inhalt der Reflexion ist subjektiv, weshalb Koole et al. vorschlagen, dass sich die Bewertung auf allgemeine Prozessfähigkeiten konzentrieren sollte [29]. Daher fokussieren die meisten Instrumente, die für die Bewertung von Reflexionsaufsätzen verwendet werden (einschließlich MaReS), auf den Prozess der Reflexion und nicht auf den Umgang mit einer Situation. Dennoch scheinen einige Studierende das Bedürfnis nach einem Kommentar zur Situation zu haben, denn eine Studierende erwähnte, dass das Feedback keine Auswirkungen auf ihn/sie hatte, weil nur die Struktur des Textes und nicht die Situation selbst bewertet wurde. Die Lehrenden sollten sich auch darüber im Klaren sein, dass die Aufsätze sehr persönliche Inhalte der Studierenden enthalten können. So könnten beispielsweise Beschreibungen von emotionalen Belastungen, Krankheiten oder traumatischen Erlebnissen in den Berichten enthalten sein. Daher sollten die Lehrenden im Voraus überlegen, wo sie Unterstützung finden können und wie sie in solchen Fällen reagieren werden.

Bei effektivem Feedback werden Informationen über frühere Leistungen genutzt, um eine positive und wünschenswerte Entwicklung zu fördern [2]. Die Studierenden empfanden das Feedback, das sie mit MaReS erhielten, als konstruktiv, hilfreich und nicht wertend.

Das Erreichen von Stufe 2 des New-World-Kirkpatrick-Modells [26] wird für MaReS eine Herausforderung darstellen, da die Reflexionsfähigkeit kontextabhängig ist. Moniz et al. schließen aus ihrer Studie über die Verwendung von reflektierendem Schreiben zur Beurteilung von Schüler*innen, dass für aussagekräftige Schlussfolgerungen über die Reflexionsfähigkeit etwa 14 Schreibproben pro Schüler*in erforderlich sind, die jeweils von vier oder fünf Beurteilenden bewertet werden [40]. Diese Schlussfolgerung wirft Fragen über die Durchführbarkeit der summativen Bewertung von reflektierendem Schreiben auf. Auch die Ergebnisse unserer Studie weisen in die gleiche Richtung: Obwohl das Feedback-Instrument überwiegend positiv bewertet wurde, fühlte sich die Hälfte der Studierenden beim Verfassen ihres zweiten Aufsatzes etwas weniger sicher – und ihre Freitext-Antworten deuteten darauf hin, dass dieses Gefühl mit der Situation zusammenhing, die sie für die zweite Reflexion gewählt hatten (z. B. Probleme, ein Thema für die zweite Reflexion zu finden).

5. Schlussfolgerung

Die Magdeburger Reflexionsskala (MaReS) kann als Instrument verwendet werden, um das reflektierende Schreiben der Studierenden anzuleiten und strukturiertes Feedback in der Ausbildung von Gesundheitsberufen zu geben. In dieser Studie war die IRR für sieben der zwölf Items niedrig. Wir gehen davon aus, dass die Schulung der Bewertenden – bestehend aus der Bewertung und Diskussion eines exemplarischen Aufsatzes – nicht ausreichend war. Die Verwendung von mehr Aufsätzen für ein Training der Bewertenden und mehr Trainingszyklen würden wahrscheinlich zu höheren IRRs führen. Eine durchschnittliche Bewertungszeit von 13,9 Minuten scheint praktikabel und könnte sich verkürzen, wenn die Bewertenden mehr Erfahrung sammeln. Wenn Lehrende Reflexionsberichte und deren Bewertung in ein Curriculum einbinden möchten, muss bei der Planung der Ressourcen ausreichend Zeit für die Schulung der Bewertenden eingeplant werden. Vorsicht ist geboten, wenn eine summative Bewertung des reflektierenden Schreibens eingesetzt wird, unabhängig davon, welches Instrument verwendet wird, da die Vorhersagbarkeit des Ergebnisses von einem Aufsatz zum nächsten gering ist.

Die wenigen Studierenden, die ein Feedback zu MaReS gaben, hielten das Instrument für nachvollziehbar und hilfreich. Um diese Ergebnisse zu untermauern, sind weitere Studien mit einer größeren Anzahl von Studierenden erforderlich. Das Sammeln von Belegen für die Kirkpatrick-Stufen zwei und höher wird aufgrund der Kontextspezifität der Reflexionsfähigkeit eine Herausforderung darstellen.

Wir empfehlen MaReS als Instrument für den Unterricht und die formative Bewertung schriftlicher Reflexionen von Studierenden in der Ausbildung von Gesundheitsberufen, z. B. über klinische Erfahrungen während des Praktischen Jahres, der Famulatur oder der Blockausbildung, aber auch über Lernerfahrungen im Allgemeinen.

ORCIDs der Autor*innen

- Anja Härtl: [0009-0008-0818-6213]

- Stefan Rüttermann: 0000-0002-2293-8089

- Linn Hempel: [0009-0009-5421-2029]

Danksagung

Wir bedanken uns bei den Mitgliedern des Ausschusses „Kommunikative und soziale Kompetenzen“ (KusK) und den Expert*innen für die gute Zusammenarbeit und ihre Unterstützung.

Interessenkonflikt

Die Autor*innen erklären, dass sie keinen Interessenkonflikt im Zusammenhang mit diesem Artikel haben.

Literatur

[1] American Educational Research Association; American Psychological Association, National Council on Measurement in Education. Standards for Educational and Psychological Testing. Washington, DC: American Educational Research Association; 1999.[2] Archer JC. State of the science in health professional education: effective feedback. Med Educ. 2010;44(1):101-108. DOI: 10.1111/j.1365-2923.2009.03546.x

[3] Aronson L, Niehaus B, Hill-Sakurai L, Lai C, O’Sullivan PS. A comparison of two methods of teaching reflective ability in Year 3 medical students. Med Educ. 2012;46(8):807-814. DOI: 10.1111/j.1365-2923.2012.04299.x

[4] Aronson L, Niehaus B, Lindow J, Robertson PA, O'Sullivan PS. Development and pilot testing of a reflective learning guide for medical education. Med Teach. 2011;33(10):e515-e521. DOI: 10.3109/0142159X.2011.599894

[5] Bok HG, Jaarsma DA, Teunissen PW, van der Vleuten CP, van Beukelen P. Development and validation of a competency framework for veterinarians. J Vet Med Educ. 2011;38(3):262-269. DOI: 10.3138/jvme.38.3.262

[6] Bolton G. Reflective Practice. Writing Professional Development. Third Edition. London: SAGE; 2010.

[7] Chu SY, Lin CW, Lin MJ, Wen CC. Psychosocial issues discovered through reflective group dialogue between medical students. BMC Med Educ. 2018;18(1):12. DOI: 10.1186/s12909-017-1114-x

[8] Cohen J. Statistical power analysis for the behavioral sciences. 2nd ed. Hillsdale, NJ: L. Erlbaum Associates; 1988.

[9] Cruess SR, Cruess RL, Steinert Y. Supporting the development of a professional identity: General principles. Med Teach. 2019;41(6):641-649. DOI: 10.1080/0142159X.2018.1536260

[10] Devi V, Abraham RR, Kamath U. Teaching and Assessing Reflecting Skills among Undergraduate Medical Students Experiencing Research. J Clin Diagn Res. 2017;11(1):jc01-jc05. DOI: 10.7860/JCDR/2017/20186.9142

[11] Devlin MJ, Mutnick A, Balmer D, Richards BF. Clerkship-based reflective writing: a rubric for feedback. Med Educ. 2010;44(11):1143-1144. DOI: 10.1111/j.1365-2923.2010.03815.x

[12] Downing SM. Validity: on the meaningful interpretation of assessment data. Med Educ. 2003;37:830–837. DOI: 10.1046/j.1365-2923.2003.01594.x

[13] European Association of Establishments for Veterinary Education (EAEVE); Federation of Veterinarians of Europe (FVE). European System of Evaluation of Veterinary Training (ESEVT). Manual of Standard of Operation Procedure. Wien: EAEVE; 2019. Zugänglich unter/available from: https://www.eaeve.org/fileadmin/downloads/SOP/ESEVT_SOP_2019_adopted_by_the_32nd_GA_in_Zagreb_on_30_May_2019.pdf

[14] Fink A. Survey Research Methods. In: Peterson P, Baker E, McGaw B, editors. International Encyclopedia of Education. Third Edition. Amsterdam: Elsevier Science; 2010. p.152-160. DOI: 10.1016/B978-0-08-044894-7.00296-7

[15] Fleiss JL. Statistical methods for rates and proportions. 2nd ed. New York: Wiley-Interscience; 1981.

[16] Frank J, Snell L, Sherbino J. CanMEDS 2015 Physician Competency Framework. Ottawa: Royal College of Physicians and Surgeons of Canada; 2015.

[17] Fries JF. Neue oder anthropologische Kritik der Vernunft. Bd. 2. Zweite Auflage. 1831.

[18] Grierson L, Winemaker S, Taniguchi A, Howard M, Marshall D, Zazulak J. The reliability characteristics of the REFLECT rubric for assessing reflective capacity through expressive writing assignments: A replication study. Perspect Med Educ. 2020;9(5):281-285. DOI: 10.1007/s40037-020-00611-2

[19] Haramati A, Cotton S, Padmore JS, Wald HS, Weissinger PA. Strategies to promote resilience, empathy and well-being in the health professions: Insights from the 2015 CENTILE Conference. Med Teach. 2017;39(2):118-119. DOI: 10.1080/0142159X.2017.1279278

[20] Heimes S. Warum Schreiben hilft: Die Wirksamkeitsnachweise zur Poesietherapie. Göttingen: Vandenhoeck&Ruprecht GmbH&Co.KG; 2012. DOI: 10.13109/9783666401619

[21] Hewson MG, Little ML. Giving Feedback in Medical Education: verification of recommended techniques. J Gen Intern Med. 1998;13(2):111-116. DOI: 10.1046/j.1525-1497.1998.00027.x

[22] Hunter DM, Jones RM, Randhawa BS. The use of holistic versus analytic scoring for large-scale assessment of writing. Can J Program Eval. 1996;11(2):61. DOI: 10.3138/cjpe.11.00

[23] Johns C. Framing learning through reflection within Carper's fundamental ways of knowing in nursing. J Adv Nurs. 1995;22(2):226-234. DOI: 10.1046/j.1365-2648.1995.22020226.x

[24] Jonsson A, Svingby G. The use of scoring rubrics: Reliability, validity and educational consequences. Educ Res Rev. 2007;2(2):130-144. DOI: 10.1016/j.edurev.2007.05.002

[25] Kant I. Kritik der reinen Vernunft. 2. Auflage. Berlin: de Gruyter; 1968.

[26] Kirkpatrick JD, Kirkpatrick WK. Kirkpatrick’s Four Levels of Training Evaluation. Alexandria, VA: ATD Press; 2016.

[27] Kiss A, Steiner C, Grossman P, Langewitz W, Tschudi P, Kiessling C. Students' satisfaction with general practitioners' feedback to their reflective writing: a randomized controlled trial. Can Med Educ J. 2017;8(4):e54-e59. DOI: 10.36834/cmej.36929

[28] Koh YH, Wong ML, Lee JJ. Medical students' reflective writing about a task-based learning experience on public health communication. Med Teach. 2014;36(2):121-129. DOI: 10.3109/0142159X.2013.849329

[29] Koole S, Dornan T, Aper L, Scherpbier A, Valcke M, Cohen-Schotanus J, Derese A. Factors confounding the assessment of reflection: a critical review. BMC Med Educ. 2011;11:104. DOI: 10.1186/1472-6920-11-104

[30] Learman LA, Autry AM, O’Sullivan P. Reliability and validity of reflection exercises for obstetrics and gynecology residents. Am J Obstet Gynecol. 2008;198(4):461.e1-8. DOI: 10.1016/j.ajog.2007.12.021

[31] Lim JY, Ong SY, Ng CY, Chan KL, Wu SY, So WZ, Tey GJ, Lam YX, Gao NL, Lim YX, Tay RY, Leong IT, Rahman ND, Chiam M, Lim C, Phua GL, Murugam V, Ong EK, Krishna LK. A systematic scoping review of reflective writing in medical education. BMC Med Educ. 2023;23(1):12. DOI: 10.1186/s12909-022-03924-4

[32] Lovell BL, Lee RT. Burnout and health promotion in veterinary medicine. Can Vet J. 2013;54(8):790-791.

[33] Lutz G, Scheffler C, Edelhaeuser F, Tauschel D, Neumann M. A reflective practice intervention for professional development, reduced stress and improved patient care – a qualitative developmental evaluation. Patient Educ Couns. 2013;92(3):337-345. DOI: 10.1016/j.pec.2013.03.020

[34] Lyon P, Letschka P, Ainsworth T, Haq I. An exploratory study of the potential learning benefits for medical students in collaborative drawing: creativity, reflection and 'critical looking'. BMC Med Educ. 2013;13:86. DOI: 10.1186/1472-6920-13-86

[35] Makoul G, Zick AB, Aakhus M, Neely KJ, Roemer PE. Using an online forum to encourage reflection about difficult conversations in medicine. Patient Educ Couns. 2010;79(1):83-86. DOI: 10.1016/j.pec.2009.07.027

[36] Medizinischer Fakultätentag (MFT). Nationaler Kompetenzbasierter Lernzielkatalog Medizin. Berlin: MFT; 2015.

[37] Messick S. Validity of test interpretation and use. In: Alkin MC, editor. Encyclopedia of Educational Research. 6th ed. New York: Macmillan; 1991.

[38] Messick S. Validity. In: Linn RL, editor. The American Council on Education/Macmillan series on higher education Educational measurement. New York: Macmillan; 1989. p.13-103.

[39] Miller-Kuhlman R, O’Sullivan PS, Aronson L. Essential steps in developing best practices to assess reflective skill: A comparison of two rubrics. Med Teach. 2016;38(1):75-81. DOI: 10.3109/0142159X.2015.1034662

[40] Moniz T, Arntfield S, Miller K, Lingard L, Watling C, Regehr G. Considerations in the use of reflective writing for student assessment: issues of reliability and validity. Med Educ. 2015;49(9):901-908. DOI: 10.1111/medu.12771

[41] Moon JA. A handbook of reflective and experiential learning: Theory and practice. London: Psychology Press; 2004.

[42] Moskal BM. Developing Classroom Performance Assessments and Scoring Rubrics-Part II. ERIC Digest. 2003. Zugänglich unter/available from: https://eric.ed.gov/?id=ED481715

[43] Moskal BM. Scoring rubrics: what, when and how? Pract Assess Res Eval. 2000;7(3). Zugänglich unter/available from: http://pareonline.net/getvn.asp?v=7&n=34

[44] O’Sullivan P, Aronson L, Chittenden E, Niehaus B, Learman L. Reflective ability rubric and user guide. MedEdPortal. 2010. DOI: 10.15766/mep_2374-8265.8133

[45] OIE. OIE recommendations on the Competencies of graduating veterinarians (‘Day 1 graduates’) to assure National Veterinary Services of quality. Paris: OIE; 2012.

[46] Ottenberg AL, Pasalic D, Bui GT, Pawlina W. An analysis of reflective writing early in the medical curriculum: The relationship between reflective capacity and academic achievement. Med Teach. 2016;38(7):724-729. DOI: 10.3109/0142159X.2015.1112890

[47] Pee B, Woodman T, Fry H, Davenport ES. Appraising and assessing reflection in students' writing on a structured worksheet. Med Educ. 2002;36(6):575-585. DOI: 10.1046/j.1365-2923.2002.01227.x

[48] Pennebaker JW. Opening up: The healing power of expressing emotions. London, New York: Guildford Press; 1997.

[49] Randolph JJ. Free-marginal multirater kappa (multirater κfree): an alternative to Fleiss’ fixed-Marginal multirater kappa. In: Paper presented at the Joensuu Learning and Instruction Symposium, Joensuu, Finland. 2005. Zugänglich unter/available from: https://www.researchgate.net/publication/224890485_Free-Marginal_Multirater_Kappa_multirater_kfree_An_Alternative_to_Fleiss_Fixed-Marginal_Multirater_Kappa

[50] Reis SP, Wald HS, Monroe AD, Borkan JM. Begin the BEGAN (The Brown Educational Guide to the Analysis of Narrative) – A framework for enhancing educational impact of faculty feedback to students’ reflective writing. Patient Educ Couns. 2010;80(2):253-259. DOI: 10.1016/j.pec.2009.11.014

[51] Sandars J. The use of reflection in medical education: AMEE Guide No. 44. Med Teach. 2009;31(8):685-695. DOI: 10.1080/01421590903050374

[52] Sandars J, Murray C. Digital storytelling for reflection in undergraduate medical education: a pilot study. Educ Prim Care. 2009;20(6):441-444. DOI: 10.1080/14739879.2009.11493832

[53] Shapiro J, Rakhra P, Wong A. The stories they tell: How third year medical students portray patients, family members, physicians, and themselves in difficult encounters. Med Teach. 2016;38(10):1033-1040. DOI: 10.3109/0142159X.2016.1147535

[54] Stevens DD, Cooper JE. Journal Keeping: How to Use Reflective Writing for Learning, Teaching, Professional Insight and Positive Change. Sterling (VA): Stylus Publishing; 2009.

[55] Uygur J, Stuart E, De Paor M, Wallace E, Duffy S, O’Shea M, Smith S, Pawlikowska T. A Best Evidence in Medical Education systematic review to determine the most effective teaching methods that develop reflection in medical students: BEME Guide No. 51. Med Teach. 2019;41(1):3-16. DOI: 10.1080/0142159X.2018.1505037

[56] Wald HS. Professional identity (trans)formation in medical education: reflection, relationship, resilience. Acad Med. 2015;90(6):701-706. DOI: 10.1097/ACM.0000000000000731

[57] Wald HS, Borkan JM, Taylor JS, Anthony D, Reis SP. Fostering and evaluating reflective capacity in medical education: developing the REFLECT rubric for assessing reflective writing. Acad Med. 2012;87(1):41-50. DOI: 10.1097/ACM.0b013e31823b55fa

[58] Wald HS, Haramati A, Bachner YG, Urkin J. Promoting resiliency for interprofessional faculty and senior medical students: Outcomes of a workshop using mind-body medicine and interactive reflective writing. Med Teach. 2016;38(5):525-528. DOI: 10.3109/0142159X.2016.1150980

[59] Wald HS, Reis SP, Borkan JM. Reflection rubric development: evaluating medical students’ reflective writing. Med Educ. 2009;43(11):1110-1111.

[60] West CP. Physician Well-Being: Expanding the Triple Aim. J Gen Intern Med. 2016;31(5):458-459. DOI: 10.1007/s11606-016-3641-2

[61] Wong FK, Kember D, Chung LY, Yan L. Assessing the level of student reflection from reflective journals. J Adv Nurs. 1995;22(1):48-57. DOI: 10.1046/j.1365-2648.1995.22010048.x

Anhänge

| Anhang 1 | Magdeburger Reflexionsskala (Anhang_1.pdf, application/pdf, 266.91 KBytes) |